Come Scrivere una Colonna Sonora da Trailer Epico

Come comporre una tipica colonna sonora da trailer di film epico? In questo articolo ti guido alle fasi principali.

Prima di tutto, ascolta il risultato finale, qui sotto. È un brano semplice ma efficace, che ho composto in una mattina. È bastato preparare uno schema e rispettarlo.

Nel corso di questa guida adopero il brano qui sopra come riferimento pratico per spiegarti in dettaglio tutti gli elementi chiave della musica “epica” di oggi.

Troverai anche la descrizione di tante tecniche essenziali per chi lavora con i sequencer e le library orchestrali.

Seguendo lo schema che ti presento in questa grande Guida gratuita, potrai facilmente ottenere risultati simili in poco tempo.

[toc]

Differenza tra trailer epico di oggi e musica da film del passato

Una caratteristica della musica da trailer di oggi è che in genere non si tratta di pezzi complessi di musica orchestrale.

Pensa alle musiche di John Williams: oltre che opere d’arte sono composizioni di musica classica formalmente impeccabili.

Invece il brano sul quale lavoriamo appartiene al genere più in voga in questo momento, quello hybrid orchestral.

In un brano da trailer difficilmente avrai una delicata variazione affidata ai woodwinds.

Quello che cerchi, in un certo senso, è un muro di suono che tenga costantemente in tensione lo spettatore.

Una specie di rave orchestrale, se vogliamo metterla così.

“La musica da trailer è una specie di rave orchestrale” Condividi su FacebookHybrid è la parola chiave: significa che in un brano di questo genere trovi elementi dell’orchestra classica — come le sezioni degli archi e degli ottoni — e suoni sintetizzati: percussioni campionate e manipolate digitalmente, sintetizzatori, processing del suono aggressivo.

Questo genere, che è quello che oggi senti più spesso al cinema, tende a seguire uno schema abbastanza prevedibile.

Come nasce questo brano: dallo scherzo al tutorial

Il brano che adopero per mostrarti i meccanismi di questo genere musicale è nato come uno scherzo, una parodia, che ho composto per passatempo una domenica mattina.

Puoi ascoltare quella prima versione andando sul mio SoundCloud, dove l’ho caricata per scherzare con degli amici compositori.

Mi ha sorpreso quante persone l’abbiano apprezzato e abbiano fatto notare che, anche se scritto per gioco, era molto vicino a un brano “vero”, che avrebbe potuto essere usato in produzione.

Il fatto è che una parodia, per forza di cose, deve somigliare all’originale. In effetti parodia viene dal greco e dall’unione delle parole παρά (affine, simile) e ᾠδή (ode, canto) — tradotte letteralmente viene fuori che una parodia è proprio una “canzone simile”.

Le parodie a volte sono utilissime: in questo articolo su come si scrive una canzone suggerisco di seguire la Generic Love Song dei The Axis of Awesome, un pezzo ironico ma ottimo come schema per comporre un brano perché illustra perfettamente tutti gli elementi di una canzone.

E la parodia diventa quindi una guida, un tutorial. Come in questo caso.

Come scrivere musica epica

Qui sotto c’è la “lista a punti” che ho usato per scrivere il brano originale.

Li elenco brevemente, così come li avevo annotati. Per i più utili, scendo nei dettagli tecnici o artistici.

“7+1 Trucchi per Scrivere Musica da Trailer” Condividi su FacebookNon seguire tutta la mia “checklist”: rischieresti di ottenere un effetto comico (almeno per le orecchie di un compositore classico).

Applicandola invece come schema di riferimento potrai ottenere un risultato che — se non certo innovativo — funziona bene.

Le regole della musica da trailer

- Un particolare ostinato di violini, che in inglese viene chiamato chugga chugga.

- Una semplice melodia, non più lunga di due battute e affidata ai French Horn.

- Accordi di ottoni che scandiscono il brano, in pratica i famosi BRAAAM di Inception.

- Limiter al massimo. Il limiter è un effetto audio che dovrebbe essere usato per prevenire picchi di segnale. Nella pratica, è diventato uno strumento per spingere al massimo l’intensità sonora dei brani riducendone la gamma dinamica.

- Percussioni da Damage, una library di Native Instruments che insieme a Stormdrum di EastWest compare spesso nelle colonne sonore hollywoodiane, tanto da essere quasi un tormentone per noi compositori.

- Tempo in 12/8. Da Pirati dei Caraibi a Superman: scandire il tempo in 12/8 è l’ideale per dare un senso di urgenza a un brano. Per sentirne il feel prova a solfeggiare un 4/4 usando delle terzine: sentirai insieme la divisione classica del 4/4, a cui siamo tutti abituati, con un accento più drammatico e incalzante.

- Un sintetizzatore che fa da drone, suona cioè un’unica nota di accompagnamento per tutta la durata del brano. È quello che succede anche nella cornamusa e in molti strumenti etnici, nei quali il senso dell’armonia è dato dal rapporto tra questa nota fissa di fondo e il movimento della melodia.

- Una serie infinita di accordi suonati dall’intera orchestra nel finale. Questi sono la parte dove ho scherzato di più, e che ho tolto nella versione per questo tutorial (lasciandone comunque tre). Serve a dare l’idea del senso di “fine-del-mondo”, ed è molto comune.

Il Chugga Chugga e la musica d’azione

Chugga Chugga è il termine onomatopeico che indica un elemento diffusissimo nella musica per film d’azione di oggi.

È il pattern ritmico che i violini ripetono a partire dal secondo 22 di questo video: il trailer con il tema di Bruce Wayne in “Batman Begins”, scritto da Hans Zimmer nel 2005.

Il termine Chugga Chugga si usava per i riff nella musica hardcore e punk degli anni ’90. Nella musica classica il riff si chiama ostinato, come ho spiegato nell’articolo sulla colonna sonora del Trono di Spade, mentre Chugga Chugga ha un’accezione dispregiativa.

Non sono riuscita a ricostruire quando, o da chi, sia stato scelto per identificare un particolare tipo di ostinato nella musica da film, ma il suo legame ufficiale con la musica d’azione inizia proprio dal trailer di “Batman Begins”.

Come scrivere l’ostinato dei film d’azione

La musica di Zimmer racchiude le caratteristiche tipiche del chugga chugga. Per riprodurlo devi tenere presenti questi elementi:

- È affidato agli archi, strumenti perfetti per eseguire passaggi molto veloci e con un timbro drammatico, ideale per costruire l’atmosfera tesa dei film d’azione.

- Inizia da solo, o comunque nettamente in primo piano rispetto agli altri elementi della musica. In Batman Begins l’ostinato inizia in piano, da solo, e poi viene progressivamente affiancato dagli altri elementi.

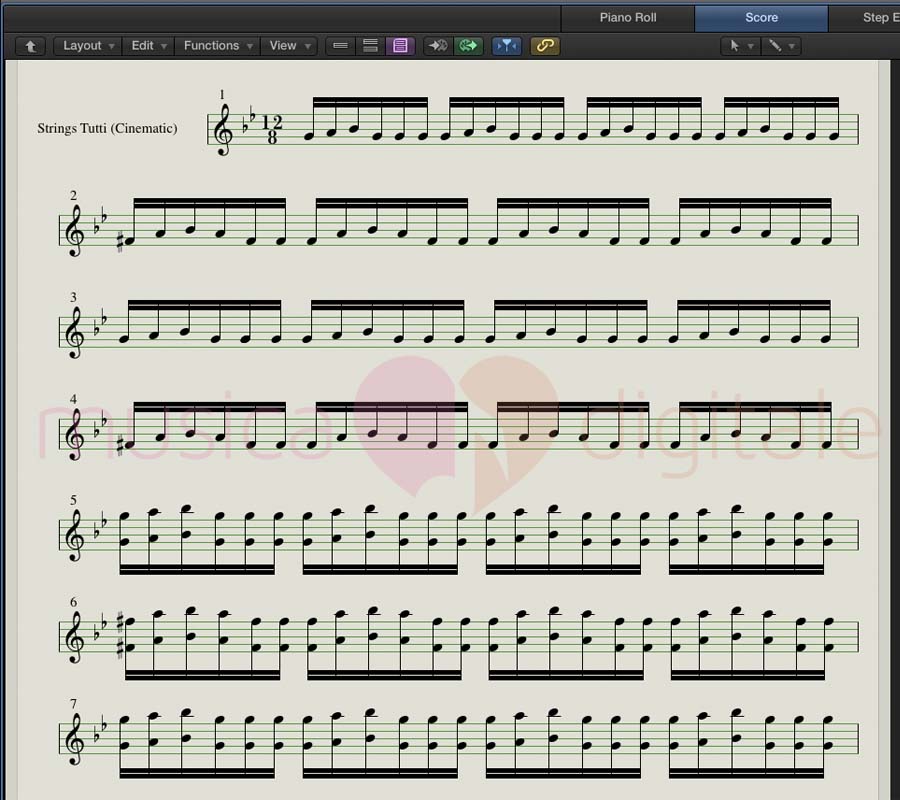

- Lo Staccato. Per riprodurre il chugga chugga nel tuo sequencer ti serve una library che abbia una buona articolazione in staccato. Quest’articolazione permette di far sentire al meglio gli accenti dell’ostinato e quindi di dare più ritmo al passaggio. Nel brano d’esempio ho usato le CinematicStrings2 con l’articolazione Staccatissimo.

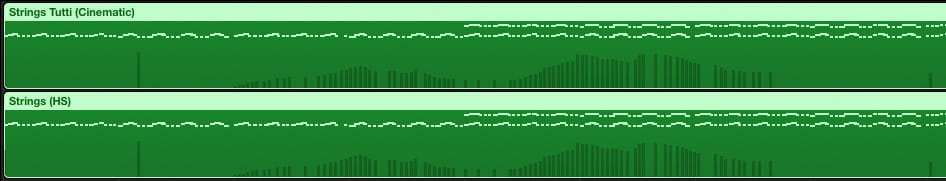

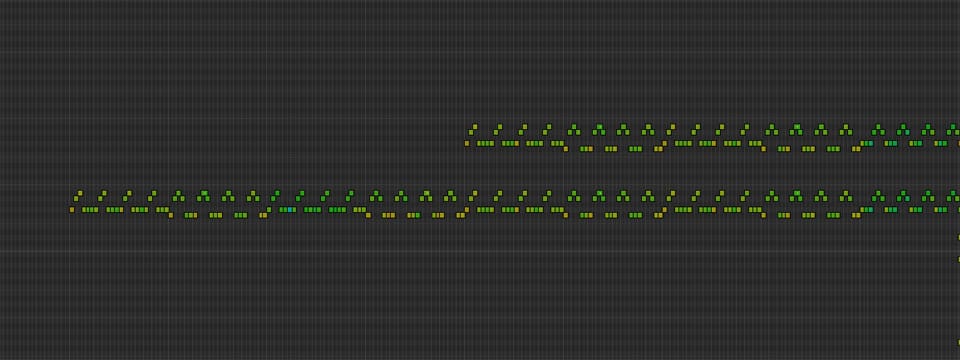

- Il Layering. Il layering, o sovrapposizione, consiste nell’usare diverse library per una singola traccia dello stesso brano, ed è un elemento chiave nel realismo dei mockup orchestrali.

Qui ho usato un layering con le Hollywood Strings di EastWest che si fondono molto bene con le Cinematic Strings.

Scendo più nei dettagli del Layering alla fine di questa guida, anche se è un argomento sterminato. Se ti interessa approfondirlo, lo troverai trattato ampiamente nel mio corso di Musica Digitale.

Per adesso torniamo al midi e alla parte puramente musicale.

Questa è la sezione delle strings come appare nel sequencer:

Se invece ti trovi più a tuo agio con le partiture:

L’ostinato nella score view di Logic Pro X.

L’ostinato nella score view di Logic Pro X.Niente conservatorio? Nessun problema.

Se fai musica ibrida ma non hai una formazione classica alle spalle, niente panico.

La tecnologia aiuta: library di strumenti virtuali e sequencer ti permettono di creare facilmente un Chugga Chugga di tutto rispetto.

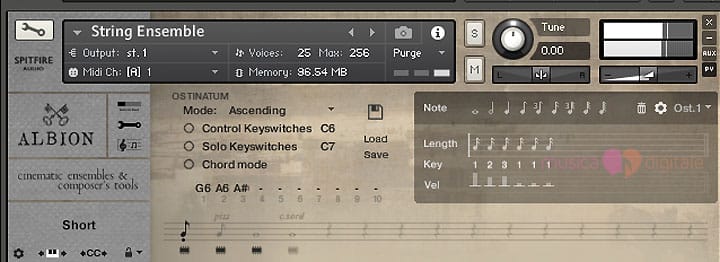

Ostinatum di Albion

Se possiedi l’ormai defunta (e risorta) Spitfire Albion I, il divertentissimo e utile Ostinatum è un’alternativa efficace.

La prima parte dell’ostinato di questo esempio si otterrebbe con un setup come questo:

L’interfaccia di Ostinatum è stata progettata davvero bene: decidi la durata delle note, la sequenza di ripetizione (indicata dai numeri) e gli accenti (con i piccoli fader di velocity sotto ciascuna nota).

Così bastano appena un paio di minuti per disegnare il Chugga Chugga dell’immagine sopra, che suona in questo modo:

Questo frammento è il risultato immediato che ti dà Albion, quindi puoi notare la ripetizione poco naturale, ma basta appena un po’ di lavoro con i CC midi (o un layering) per dargli realismo.

Library orchestrali basate su frasi

Ancora, probabilmente esistono infinite varianti di Chugga Chugga nelle ActionStrings incluse con Komplete 10 Ultimate di Native Instruments o nelle library basate su frasi di Sonokinetic (in particolare Grosso, che è registrata proprio nel tempo composto di 12/8 di cui ho parlato prima).

Compositori professionisti e appassionati di musica classica: lo so, non c’è nulla di nuovo in questi ostinati di strings, li ascoltiamo sin dalla musica del diciottesimo secolo.

È solo negli ultimi anni, però, che sono diventati praticamente obbligatori in ogni brano. E sono anche la cosa che i detrattori della musica epica di oggi dileggiano con più scioltezza.

Per chi, come me, considera John Williams il più grande compositore vivente, prima di criticare il Chugga Chugga reso popolare da Zimmer è il caso di riascoltare la colonna sonora de L’Impero Colpisce Ancora , del 1980.

Ecco di nuovo, a 16 secondi dall’inizio, il nostro chugga chugga, inserito nella cornice classica tipica della musica di Williams.

Scrivere la melodia di un trailer: il French Horn

Questa è la parte più divertente. Non sostengo che si tratti di una regola assoluta, anzi, ho già trovato tante eccezioni, ma la maggior parte delle melodie è molto breve ed è affidata praticamente sempre ai corni (French Horn).

Nel brano che ho usato come esempio per questa guida, la melodia che ho scritto è semplicissima, guarda:

Quello che vedi è la melodia suonata dai corni nel sequencer e quindi già trasposta in F.

Il suono dei corni è legato ai campi di battaglia e alle scene di caccia: è probabilmente per questo motivo che da sempre vengono usati nella musica per film d’azione.

Il corno francese, in particolare, è uno strumento poderoso e dal timbro epico, ma anche un po’ malinconico.

Non è squillante come la tromba (il “soprano” dei brass) usata in così tanti temi classici, nelle atmosfere avventurose e nei western.

Oggi la tromba potrebbe suonare antiquata, troppo legata all’eroismo puro, al cliché dell’eroe “senza macchia e senza paura” che il cinema di oggi cerca di evitare.

Musica da film e tecniche narrative vanno di pari passo.

La musica deve aderire all’azione e ai sentimenti espressi dalle immagini. Ma il modo in cui lo fa cambia col passare degli anni, perché cambia il modo di raccontare le storie.

Quando ho iniziato ad applicare la mia formazione in teoria cinematografica all’analisi delle scene, la musica per immagini che componevo è cambiata in meglio.

Il cinema di oggi procede spesso per sottrazione, abbassando il tono proprio quando i sentimenti si fanno più intensi.

Pensa a Liam Neeson in “Taken” e al suo monologo entrato ormai nella storia del cinema, quello di lui al telefono che inizia con “I don’t know who you are, I don’t know what you want…”.

In passato sarebbe stato probabilmente accompagnato da un crescendo continuo di ottoni fino a un fortissimo finale sulla battuta “I will kill you”.

Proprio l’opposto dell’efficace underscore composto da Nathaniel Méchaly che invece accompagna la scena.

Pensa anche a scene come una nell’ultimo Avengers. [SPOILER ALERT] Mi riferisco alla scena dove Chris Hemsworth, fronteggiando Ultron, recita “sono Thor, Dio del Tuono, Figlio di Odino…” (monologo epico e che funziona) e poi improvvisamente rovescia la situazione aggiungendo “…e sono a corto di cose da dire” perché il suo monologo si svela essere solo un diversivo — tanto per Ultron quanto per gli spettatori.

Sono due esempi di come la tendenza del film epico di oggi sia quella di evitare di essere stucchevole, e il corno francese riassume alla perfezione questa tendenza.

Da un punto di vista sonoro, inoltre, il registro di frequenze del corno francese si colloca bene sopra ai brass più bassi, come trombone e tuba che rivestono un altro ruolo importante, del quale parlo tra un po’: gli accordi vigorosi che da Inception a oggi hanno preso il nome di BRAAAM.

Da ultimo, i compositori di musica da film di oggi hanno studiato le opere di Basil Poledouris (“Conan”, “Starship Troopers”, “Caccia a Ottobre Rosso”) che, pur rimanendo un compositore classico sotto ogni aspetto, ha anticipato il suono ibrido della musica action che ascoltiamo oggi.

Ascolta ad esempio qui sotto la sua colonna sonora per il “Robocop” originale del 1987.

A parte l’inizio, che sembra rifare il verso al finale del mio brano scherzoso, a 1m05s e specialmente a 1m34 quando entra il tema, noterai la somiglianza con i brani di oggi.

Oltre che per le bellissime colonne sonore, Poledouris rimane nella storia, almeno in quella dei compositori di musica da film, per i 24 (sì, ventiquattro) French Horn che usò nella colonna sonora di Conan — non a caso un personaggio che è un antieroe e decisamente “larger than life”.

Mantenere breve la melodia

Quanto alla breve durata delle melodie (la frase principale del bellissimo tema della serie televisiva “Gotham” è di cinque note cinque), posso solo fare l’ipotesi che si tratti di un modo per dare varietà al brano, superando però la forma classica del tema con variazioni.

In questo genere di musica, la maggior parte dell’orchestra ha infatti dei ruoli ben definiti e quasi obbligati.

- le strings negli ostinato e qualche volta in passaggi melodici

- gli high brass nella melodia, appunto, e i low brass negli accordi di sostegno

- le percussions nella scansione ritmica

- i woodwinds sono praticamente inutilizzati

Non avviene il tradizionale passaggio del tema tra strumenti, né una vera e propria chiamata e risposta tra sezioni orchestrali.

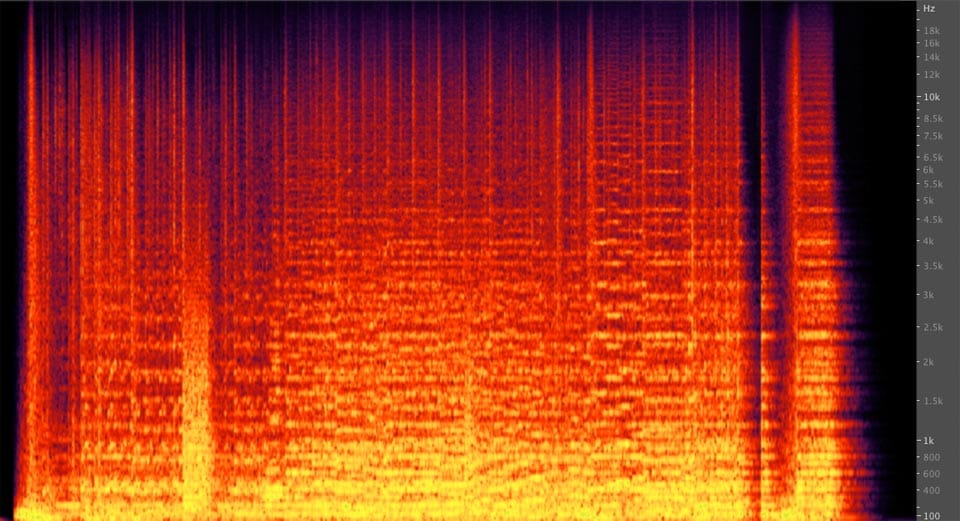

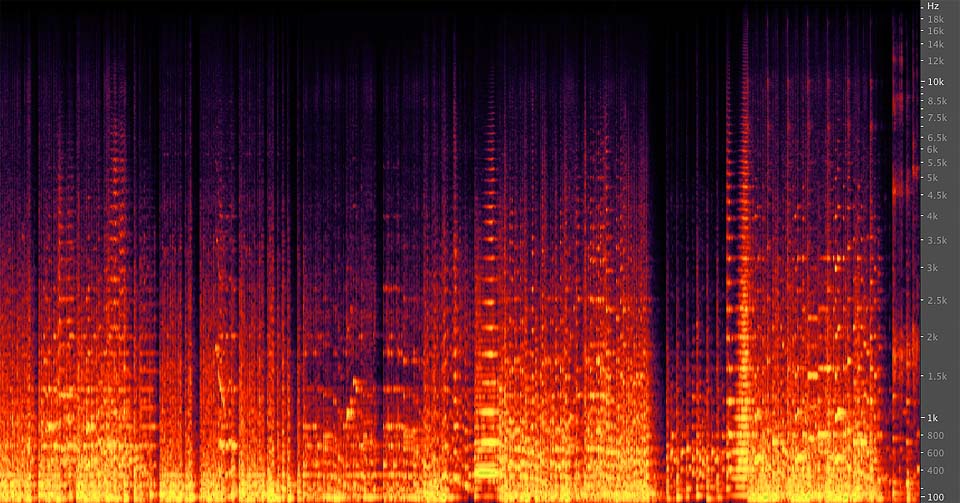

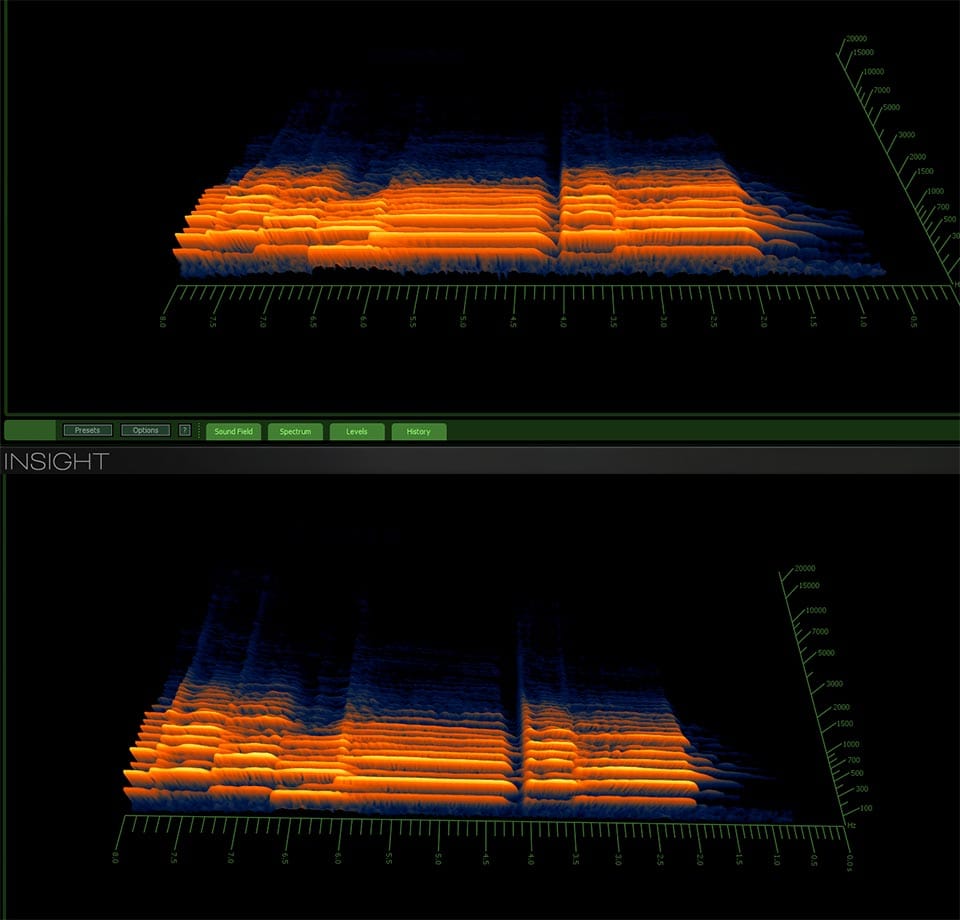

Quello che ho notato, e trovato affascinante, è che se osserviamo l’analisi spettrale delle frequenze di un brano “di oggi” e di uno classico, c’è spesso uno straordinario ordine visivo nella musica contemporanea, una compattezza che potrebbe spiegare l’utilità di melodie brevi e semplici.

Per quanto possa sembrare paradossale, in questa ripetizione di brevi schemi con graduali variazioni la musica epica di oggi è minimalista.

Differenze tra musica orchestrale ibrida e classica

Non posso naturalmente usare brani commerciali, ma posso confrontare le analisi spettrali di due miei brani, quello di cui ci occupiamo nell’articolo e un altro, completamente diverso, composto e orchestrato tradizionalmente.

Ho intenzionalmente catturato la stessa durata in entrambi i brani per evitare che lo zoom influenzasse l’effetto, come succede alle volte negli esempi sulla loudness war.

Qui sopra vedi lo spettro delle frequenze nel brano da trailer di questa guida. Nota l’ordine dato dalla suddivisione delle sezioni e l’effetto “muro di suono”.

Confrontalo con questo altro mio brano, che ho composto e orchestrato formalmente.

Completamente diverso e non ha nulla dell’ordine e della compattezza del brano sopra. Nota come le melodie si intreccino e gli strumenti continuino a sovrapporsi e a variare.

Non si tratta solo di una questione di dinamica, non dipende dal limiter e dagli effetti digitali. Nel secondo brano ti accorgi a colpo d’occhio che l’orchestrazione è più complessa e varia. Non somiglia a un muro, ma a un arabesco.

Puoi provare a caricare brani tradizionali e brani di oggi in un software con analisi spettrale (per queste analisi ho usato Adobe Audition) e noterai spesso lo stesso genere di differenze.

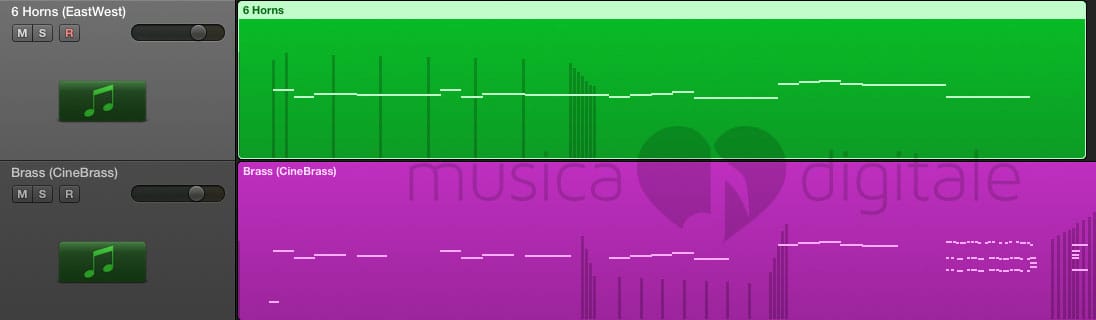

Il Layering della melodia

Ho già ripetuto più volte quanto sia importante il layering. Nella prima versione del brano, quella scherzosa, per motivi di tempo non avevo fatto layering nella sezione delle strings.

Per la melodia però non avevo potuto fare a meno di ricorrere ad un layering, nemmeno in quella prima versione realizzata velocemente.

La melodia è suonata dai French Horns degli Hollywood Brass supportati dove serve dai Cinesamples CineBrass Pro.

Nell’immagine qui sotto trovi le due tracce isolate, in modo da rendere più evidente la sovrapposizione e farti vedere come ho usato diversamente i Cinesamples rispetto agli Hollywood Brass.

Nota che non sempre entrambe le library suonano le stesse note. L’obiettivo è un suono realistico, anche se richiede un po’ di lavoro extra.

Le due library che ho usato sono molto diverse.

La serie Hollywood di EastWest è registrata nell’EastWest Studio 1 ed ha una qualità sonora eccezionale, nitida ed espressiva ma molto asciutta.

I CineBrass sono registrati in una sala con molto più carattere, il Barbra Streisand Soundstage di Sony Studios, ed hanno invece molta più aria e un forte senso di ambiente.

Unendo le due parti, come nella schermata sopra, il risultato è molto più convincente rispetto all’aver usato una sola delle due library.

Per praticità avevo usato una summing stack di Logic ProX che conteneva entrambe le parti.

In una produzione complessa, realizzata partendo da un template orchestrale, gli strumenti sarebbero già stati raggruppati per il layering.

Torno a parlare di layering alla fine di questa guida.

Accordi di Brass, i BRAAAM

Ho già raccontato tutta la storia del Braaam nell’articolo su musica e effetti sonori di Inception, con qualche consiglio su come usare questo particolare suono per creare anticipazione o minaccia.

Nella traccia che stiamo studiando, ho usato il i “braaam” in un altro modo, che sta diventando piuttosto comune: all’interno del pezzo, come una forma di suddivisione della struttura.

Sono tre in tutto. Quello centrale ha anche lo scopo di dividere in due la melodia.

Un po’ per scherzo — ho immaginato un produttore lamentarsi che la “musica vera” durava troppo — e un po’ perché funziona bene: ci sono almeno due film popolari di quest’anno dove la melodia, il “tema”, viene momentaneamente interrotto appunto in questo modo.

Dal punto di vista tecnico, ho scelto la via più breve per avere dei robusti accordi di ottoni: una libreria “ensemble” (e precisamente “Da Capo” di Sonokinetic).

Le library di Ensemble

Una library Ensemble contiene più sezioni orchestrali registrate insieme, invece dei classici singoli strumenti o sezioni.

Quindi non troverai nessun solista ma nemmeno uno strumento “Violins I” (e men che meno i divisi) o la classica formazione di quattro “French Horn”.

Hai invece a disposizione la sezione “Strings”, che include tutte le strings, quella “Brass” con tutti i brass, e così via.

Ogni nota viene suonata dagli strumenti della sezione che possono raggiungere il range di quella specifica nota.

Questo mi ha permesso di suonare gli accordi finali in un’unica traccia, senza dovermi preoccupare di orchestrarli tra gli strumenti.

Ho dato un po’ di variazione cambiando il voicing dell’accordo a ogni ripetizione.

In questo modo:

Facile e veloce, ma soprattutto molto realistico: il suono dei sample di una intera sezione di “low brass” è diverso da quello che si ottiene facendo suonare le stesse note ai singoli sample di ciascuno strumento.

Ottieni immediatamente un suono coerente e realistico, perché la presenza sonora di ogni strumento è perfettamente bilanciata con quella degli altri strumenti della sezione.

Il suono è anche molto naturale, perché senti che gli strumentisti sono presenti nello stesso momento e nello stesso ambiente.

Naturalmente le library “ensemble” non sono adatte per comporre in modo tradizionale, scrivendo la musica su carta oppure usando Finale o Sibelius.

Il grado di controllo è limitato, e non sei tu a decidere in ogni momento quale strumento suonerà una determinata nota.

Ma per la musica digitale, prodotta interamente ITB (“In The Box”, nel computer), sono strumenti estremamente utili.

Library Ensemble e Underscoring

In qualche caso gli ensemble sono separati tra low e high, e questo è molto utile per l’underscoring.

L’underscoring è in generale tutta la musica che accompagna le immagini rimanendo sotto al dialogo o all’azione (da qui under-score).

Non è quindi underscore la fanfara di Indiana Jones (difficile tenerla sotto qualsiasi altra cosa).

E non è underscore il brano dell’articolo su come comporre una colonna sonora, perché in quel caso la musica è l’unico elemento sonoro, non ha un ruolo subordinato.

C’è però un tipo particolare di underscore: quello che senti sempre e non noti quasi mai. Sono quegli accordi bassi, persistenti, che non richiamano l’attenzione ma contribuiscono a creare l’atmosfera emotiva giusta.

Questa è una delle aree dove l’uso dei sample al posto degli strumenti reali è ormai pratica consueta anche nelle produzioni più costose. E le library ensemble per questo sono utilissime.

Quando il nostro eroe si aggira di notte tra i rugginosi container del porto malfamato, bastano poche note sostenute con una sezione di low brass o low strings ensemble per sostituire efficacemente un’orchestra reale.

Perché le sezioni “low”? Semplice, il loro registro di frequenze si trova naturalmente sotto agli effetti sonori e alla voce.

Usare un Limiter nella musica orchestrale

La regola generale è che no, non si deve usare un limiter nella musica orchestrale, perché è il compositore che determina la dinamica del brano, decidendo quali strumenti suonano e indicando con i segni d’espressione se devono suonare in pianissimo o forte o fortissimo.

Cos’è la gamma dinamica?

In breve: la gamma dinamica (o dynamic range) di un brano è l’intervallo tra il volume più basso e quello più alto.

Pensa a un brano di musica classica: sentirai dei passaggi in pianissimo, poi dei mezzo forte, e magari nel finale troverai un crescendo verso un fortissimo.

La gamma dinamica di questo brano, quindi, è ampia e va dal pianissimo al fortissimo.

Prendi ora un pezzo da discoteca: qui la gamma dinamica è molto ridotta, perché ogni nota tende a essere suonata in fortissimo, c’è poco differenza tra il suono a volume più basso e quello a volume più alto.

Anche la musica da trailer epico di questi anni tende ad avere una gamma dinamica ridotta, e il Limiter è il principale strumento usato per la loudness war degli ultimi anni.

In una registrazione orchestrale si può normalizzare il segnale audio, per essere sicuri che occupi tutta l’ampiezza disponibile. Ma la normalizzazione di un file audio non altera la dinamica relativa del brano.

Non si applicano invece effetti che comprimono o espandono la dinamica.

Ci si limita invece a mixare la registrazione principale con quella delle singole sezioni orchestrali (archi, ottoni, legni, percussioni che chiamo come di consueto strings, brass, woodwinds e percussions).

- La registrazione principale è quella proveniente dal setup di microfoni passato alla storia come Decca Tree (“albero” della Decca, dal nome dell’etichetta discografica che lo inventò). Corrisponde più o meno alla posizione del direttore d’orchestra e rappresenta l’insieme della registrazione.

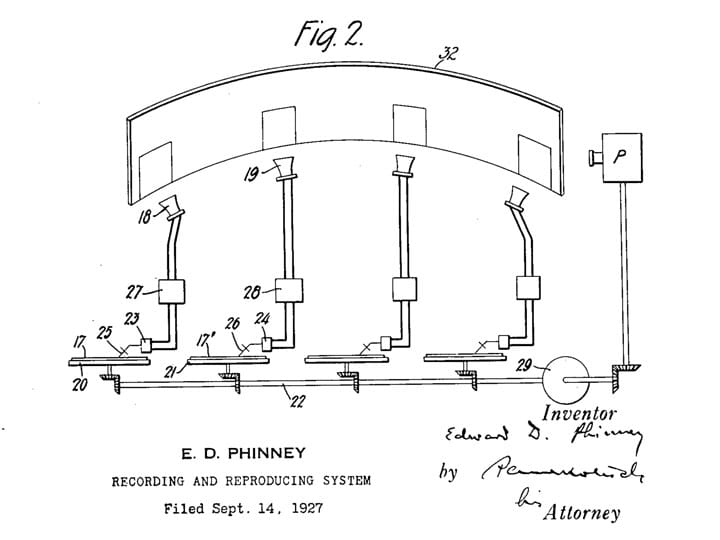

- La registrazione di una singola sezione orchestrale è ottenuta da microfoni posizionati in prossimità di quella sezione. Nelle registrazioni professionali, in studio, l’obiettivo è che ci sia il maggiore isolamento possibile tra una sezione e l’altra, in modo che ad esempio il microfono della sezione degli archi registri il meno possibile delle altre sezioni orchestrali. (In proposito leggi anche l’approfondimento alla fine della guida che menziona il brevetto Phinney.)

- Eventualmente altri microfoni catturano le riflessioni posteriori (per l’encoding surround) o vengono dedicati a strumenti particolari.

Durante la fase di mixing, si interviene per rendere più uniforme la riproduzione, per esempio automatizzando il volume delle tracce delle singole sezioni rispetto alla registrazione principale.

Ma di certo non si spinge agli estremi la loudness del brano come se fosse una canzone pop.

“Il Limiter: l'arma segreta di un brano epico.” Condividi su FacebookPer questo motivo il limiter non sarebbe in teoria necessario, perché con una buona registrazione e un mix accurato il segnale non arriva mai al peak.

Rimane però necessario come misura di sicurezza per evitare eventuali intersample peak, ovvero picchi non presenti nel segnale digitale, ma che un convertitore da digitale ad analogico potrebbe generare erroneamente durante la ricostruzione della forma d’onda.

In ogni caso il limiter deve essere impostato in modo da non amplificare mai il segnale.

Usare il limiter nella musica da trailer

Però, se vuoi il sound compresso e vigoroso dei trailer epici, il limiter serve eccome. Per questo è l’unico elemento strettamente audio nella lista che ho ti indicato sopra.

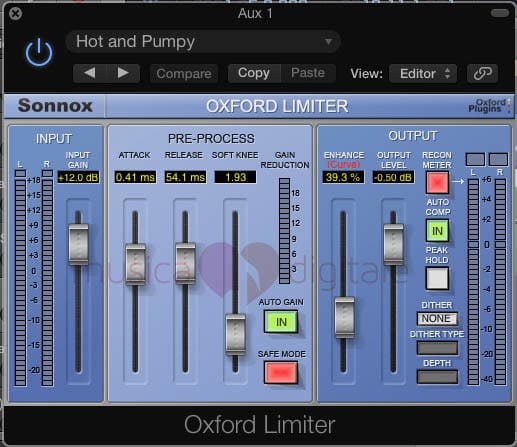

In questo caso ho adoperato il mio limiter preferito, il Sonnox (Sony-Oxford), che ancora oggi trovo di qualità superiore e che vale in pieno il suo costo di circa 330 Euro — più dell’intero Logic ProX.

Per questo brano sono partita dal preset ‘Hot and Pumpy’ ma ho portato il guadagno a +12dB. Abbastanza da amplificare i passaggi più delicati senza perdere troppo di gamma dinamica.

Il brano limitato dal Sonnox conserva una rispettabilissima gamma dinamica media di 85,9dB anche dopo la conversione a 16bit per la distribuzione.

Unito alla distorsione armonica (la funzione Enhance Curve, che non userei mai in un brano classico) il Sonnox è ciò che dà maggiormente la sonorità ibrida che cercavo.

Queste le impostazioni del Sonnox Limiter per dare vigore al brano.

Qualsiasi limiter, comunque, funzionerebbe bene per creare un suono vigoroso.

Basta regolarne la soglia di attivazione (come nel caso del Loudmax, che è gratuito) o il guadagno (come per il limiter che trovi incluso in Logic ProX) in modo da ottenere una forma d’onda non completamente schiacciata ma comunque corposa per tutta la durata del brano.

La post produzione audio professionale

Nella produzione professionale di una colonna sonora da film o da trailer sia con samples che con musicisti reali questo passaggio invece non serve, ed è anzi dannoso.

In una produzione professionale, infatti, il processing del segnale viene gestito in fase di post produzione audio durante il re-recording, cioè il mix finale di dialogo, effetti e musica e il loro posizionamento nello spazio dell’audio multicanale, seguito poi dal mastering della colonna sonora finale.

Tutto questo avviene in uno studio certificato, con ingegneri specializzati che seguono meticolosamente le specifiche del formato scelto (Dolby, DTS…) e forniscono i diversi master. Ad esempio, tra la distribuzione cinematografica e quella digitale o su supporto fisico ci sono 3dB di differenza nel livello dei canali posteriori.

Librerie di sample orchestrali e layering

Vale la pena di approfondire l’argomento library orchestrali. Già adesso ne ho adoperate cinque (“Da Capo”, “CinematicStrings2”, “Hollywood Strings”, “Hollywood Brass” e “CineBrass”) e il brano ne impiega ancora altre tre (“Damage”, “TempleDrums” di Soundiron per il drone e “CineOrch”).

Perché non affidarsi a una solo produttore di virtual instruments? Sembrerebbe essere più vantaggioso:

- Di certo sarebbe più economico.

- Nella maggior parte dei casi sarebbe anche più facile, perché ogni library va studiata. Bisogna imparare a conoscerla per sfruttarla al meglio, e se si usano i keyswitch è necessario ricordare quali articolazioni corrispondono a ciascuna library.

- Tutti gli strumenti sarebbero coerenti tra loro e spesso registrati nello stesso studio, evitando noiose operazioni di posizionamento spaziale (e potenziali errori di fase).

- Da ultimo, sarebbe più leggero in termini di risorse di sistema, come ram e (marginalmente) anche per quanto riguarda l’uso della CPU.

Ma non è detto che sia la via migliore.

Il mio parere professionale è che per una composizione virtuale realistica sia indispensabile miscelare library differenti.

Questo è un approccio che so essere condiviso dalla maggior parte dei compositori di Hollywood — inclusi quelli che hanno a disposizione library private, realizzate su misura solo per loro.

- Raramente una sola library è coerente. Troverai spesso almeno uno strumento che suona in modo meno gradevole degli altri, o un particolare campione che ha dei difetti. Più alternative ti permettono di aggirare il problema.

- Ogni library ha il suo carattere. La serie Hollywood di EastWest, a mio parere, suona in modo splendido. Ma è difficile usarla in un contesto intimo e raccolto. Di nuovo, avere un’alternativa ti permette di completare più facilmente, e meglio, ogni genere di lavoro.

- Il layering rende tutto più vero. Se sovrapponi alle CinematicStrings2 le Hollywood Strings, ottieni un suono che è molto più originale e realistico. Diventa il tuo suono.

- Il layering migliora anche la qualità della performance. Se ad esempio uno strumento ha pochi roundrobin e vuoi evitare la ripetizione a raffica dei sample, il layering con un’altra library aiuta anche in questo, dando un ulteriore livello di varietà. E due strumenti con 5 roundrobin ciascuno, significano 25 variazioni (5 x 5) e non solo 10 (2 x 5). Un grande win.

Quelli che ho elencato qui sopra sono solo i principali motivi per usare insieme diverse library di diversi produttori. Ma dovrebbero già rendere bene l’idea dei vantaggi.

Ovviamente ci sono opinioni contrarie.

C’è chi ritiene che, ad esempio, usare solo strumenti dello stesso produttore, assolutamente dry, e posizionarli con una plugin di riverbero e posizionamento spaziale dia il risultato più realistico possibile.

Questo perché simula in modo matematicamente esatto l’assorbimento delle onde sonore prodotto dall’aria, le early reflections delle pareti e il riverbero complessivo della sala.

Ricostruire il suono di una sala da concerto

Non c’è nulla di nuovo sotto al sole: è un’idea degli anni ’20.

Questa dell’isolare gli strumenti e poi riassemblarli in uno spazio virtuale che sembri vero può apparire come una diavoleria moderna possibile solo grazie a DSP, misurazione degli IR (impulse response) delle sale di registrazione e grande potenza di calcolo.

In realtà risale almeno al 1927, quando Edward Phinney brevettò un sistema per “registrare individualmente una sezione di un concerto consentendo alle qualità e caratteristiche delle sezioni individuali di essere registrate indipendentemente l’una dall’altra”.

E ancora, sempre dallo stesso brevetto, “È anche oggetto dell’invenzione usare una registrazione artificiale per ricreare la musica originale in modo tale che le sezioni separate possano essere combinate e riprodotte così che l’insieme si avvicini, quanto più possibile, all’effetto della performance originale.”

Certo, Phinney adoperava sale isolate e tunnel acustici, ma davvero quelle parole scritte quasi cento anni fa somigliano in modo impressionante alla descrizione che si fa di software come Vienna MIR Pro o Virtual Sound Stage.

Dal punto di vista pratico, se devi riunire nello stesso spazio diverse library puoi farlo facilmente mettendo in close gli strumenti e (eventualmente) eliminando il riverbero della sala già esistente.

Fino a qualche anno fa, rimuovere il riverbero era considerata un’operazione quasi impossibile.

Poi, con iZotope RX (del quale parlai anni fa in un articolo su VFX Wizard) e successivamente con altre plugin che operano sullo spettro delle frequenze è diventato possibile, in alcuni casi persino facile.

Quanto queste procedure siano efficaci puoi ascoltarlo qui sotto. Gli esempi sono compressi in mp3 e non rendono bene quanto gli originali aiff perché il riverbero è il tipo di informazione secondaria che viene compresso aggressivamente dall’mp3. Comunque, nonostante la compressione, il cambiamento è così forte che non lascia dubbi.

Esempio fatto in due secondi qui in ufficio: ambiente lungo e finestrato, quindi pieno di riflessioni sonore.

Prima c’è la registrazione audio di me che parlo a un paio di metri dal microfono e poi la versione ripulita:

Per la musica c’è da lavorare di più perché non si tratta solo di togliere i transienti (rozzamente con un gate, o analizzando il segnale come fanno gli strumenti più sofisticati, a partire da SPL De-Verb).

Per la musica diventa assolutamente necessario togliere la risonanza della sala, che si somma nota dopo nota a quello che ascoltiamo.

Qui un esempio fatto con il trombone della vecchia EastWest Symphonic Orchestra.

L’ho scelta apposta perché anche in close è una library molto “wet”, è stata registrata in sala da concerto.

Tre versioni, prima il virtual instrument, poi la versione ripulita e poi la differenza delle due ottenuta invertendo la seconda versione e sommandola alla prima.

Nella terza soprattutto noti quanto vibrato sono riuscita a togliere dal segnale originale.

Si può fare di meglio, ma è già pronto per essere messo in posizione e avere un routing verso il nuovo riverbero.

Questi sono gli spettrogrammi da Insight di iZotope, la differenza più evidente è nella coda, ma quella davvero importante è la maggiore nitidezza delle note suonate dal trombone.

Ho tolto proprio la risonanza, portando le note in primo piano. Lo noti in modo particolare nella pausa della frase, dove il primo spettrogramma ti mostra una confusa continuazione del suono, mentre il secondo rende proprio evidente che c’è una separazione.

In alto la versione originale, in basso quella trattata per eliminare il riverbero della sala da concerto.

Dagli spettrogrammi puoi anche notare come ci sia un generale decrescimento di volume (la risonanza delle note non si somma al segnale diretto) e come ogni nota sia scandita chiaramente: ho letteralmente messo a fuoco il suono.

Una buona idea è farsi uno specchietto per ciascuna library che si possiede. Ad esempio, banalmente:

DRY: VSL Vienna, Chris Hein…

STUDIO: EastWest Hollywood series, SoundIron Symphony Brass (anche se registrati in una chiesa sono piuttosto secchi)…

WET: EastWest Symphonic Orchestra, 8DIO Requiem, Cinesamples (in particolare i Woodwinds Core e Pro hanno tanta aria)…

In questo modo è facile distinguere le combinazioni che richiedono poco lavoro da quelle per le quali ne serve di più.

Meglio con l’ambiente naturale oppure senza?

Per me, usare un metodo piuttosto che l’altro dipende interamente dalla musica che ho scritto.

Il layering è sempre una necessità, ma per alcuni brani preferisco avere aria e ambiente naturali.

Per altri preferisco prendere ogni strumento in close monofonico e posizionarlo nello spazio aggiungendo poi i riverberi delle sezioni.

Questo è senz’altro un caso dove vale il principio di “ad ognuno il suo”. Giudica con le tue orecchie confrontando brani realizzati in un modo e nell’altro.

Personalmente trovo che pur essendo un brano realizzato in fretta solo l’accordo finale dell’intera orchestra sembri suonato in uno spazio differente dal resto (nella versione su SoundCloud — quella ritoccata per questa guida non ha questa imperfezione).

Sempre per motivi di tempo, su quell’ultimo accordo non avevo fatto layering: è interamente suonato dalla piccola library CineOrch di CineSamples, pensata più per sketch e underscoring che per essere ascoltata con attenzione.

Però la stessa CineOrch è presente in tutti gli accordi finali, ma miscelata al resto delle library, e quindi contribuisce a creare quello che è in fondo l’obiettivo di una musica interamente digitale: il suono di un’orchestra — non quello di un insieme finito di samples.

Se desideri imparare in modo completo e rigoroso come comporre colonne sonore epiche e da trailer, c’è il grande corso di Musica da Film nell’Accademia di Cinematografia Digitale VFX Wizard – la Prima Scuola Online d’Italia su Cinema e Musica Digitale.

Vai sul sito dell’Accademia e nella pagina descrittiva del corso, trovi tanti esempi originali di musica per immagini, con video sempre composti da Susanna Quagliariello – la tua insegnante, che ti accompagna per oltre settanta ore di lezioni pratiche e rigorose.

17 commenti

Dubbi o domande? Lascia un commento qui! (Non rispondo a messaggi privati su Facebook o altri social.)

Gentile Susanna salve, grazie per il magnifico sono che fai con le tue pubblicazioni.

Grazie 🙂

Susanna

Complimenti, articolo molto interessante che denota una conoscenza di primissimo ordine della materia trattata!!!

grazie

Luca

Grazie, Luca!

Susanna

Ciao Susanna complimenti davvero!! Volevo sapere come hai fatto a creare l’effetto iniziale del trailer (l’effetto risucchio per intenderci 😀 ) Si può fare con logic PRO?

Grazie mille,

Tommaso

Ciao Tommaso.

Il suono a cui ti riferisci si chiama in genere woosh o swoosh ed è così importante nella musica da film di oggi, specialmente per i trailer, che ci sono intere library dedicate interamente a questo tipo di suono.

L’effetto sonoro che ho usato nel brano viene da una libreria Kontakt che si chiama Rise & Hit. Permette di decidere il sound e la dinamica di singole componenti dello swoosh finale.

In Logic, senza andare a cercare uno swoosh tra i loop di effetti sonori, mi vengono in mente due modi per arrivare a un risultato simile: usando Alchemy, il sintetizzatore aggiunto nelle ultime versioni, oppure ES P, una vecchia gloria tra i sintetizzatori di Logic.

Con Alchemy Una volta aperta l’interfaccia, vai nel box ricerca e scrivi “Swoosh”: ti apparirà tra i risultati un preset con un effetto simile, che puoi personalizzare modificando i parametri delle tab di Perform, Arp e Effects. Serve la versione 10.2 di Logic Pro X.

Con ES P Il suono di default è quello del classico sintetizzatore, ma puoi modificarlo così:

In entrambi i casi, dovrai lavorare un minimo con l’automazione del Volume e aggiungere un hit di percussioni quando lo swoosh raggiunge il massimo di volume, ma l’effetto di base è questo.

Sono due giorni (e due notti) che leggo e rileggo avidamente i tuoi articoli. Sono veramente sbalordito: una miniera di informazioni esposte in maniera semplice, chiara, coerente… Ti sono davvero molto grato per averle condivise, perché non è facile trovare dei professionisti del tuo livello disposti a farlo. Non ci conosciamo ma ti invio un forte abbraccio, con dentro tutta la mia stima.

Ciao Marco, grazie mille!

Sono davvero contenta di esserti stata utile.

Ciao Susanna,

innanzitutto ti faccio i miei complimenti per il sito e per i tuoi articoli sempre molto interessanti e “pragmatici”, davvero molto utili e spiegati in modo chiaro.

Vorrei però porti alcune domande riguardo l’argomento “layering”…

Allora, intanto ho sentito pareri discordanti su questo approccio; c’è ad esempio chi addirittura sostiene che sovrapporre 2 sezioni (ad esempio di violini) prese da 2 librerie distinte (che suonino contemporaneamente, ovviamente) dia un effetto “strano e innaturale”, lontano dalla realtà…

Riguardo a ciò tu che ne pensi?

Inoltre, se io volessi nei miei brani un approccio davvero realistico, non dovrei tenere conto anche del numero di strumenti presenti in una sezione?

Mi spiego meglio con un esempio:

mettiamo che io voglia nel mio brano una sezione di 16 violini primi, ad esempio con articolazione “sustain”…perfetto, carico la sezione da una libreria che sia campionata con 16 violini, cercando l’articolazione “sustain”; ora, volendo applicare la logica del layering, dovrei caricare un’altro sample di sezione di violini, preso da una libreria differente, sempre con articolazione sustain, che vada a “doppiare” all’unisono la prima sezione (stesse note), in modo da considerare le 2 sezioni come una sezione unica… ho inteso bene fin qui?

Ok, mettiamo che io lo faccia; carico una seconda sezione di violini presi da una libreria campionata con 11 violini questa volta… risultato finale (o almeno quello che dovrebbe sembrare), 16+11= 27 violini primi…

Come può questo essere realistico, supponendo che io abbia scritto un brano prevedendo solo 16 violini in orchestra?

Altra mia riflessione…se gli 11 violini presi dalla seconda libreria eseguissero note differenti (anche solo 1 o 2 diverse), o utilizzassero ad esempio un’articolazione diversa dal “sustain” della prima libreria, automaticamente avrei applicato la “tecnica dei divisi” (poichè 16 violini eseguono una cosa, mentre 11 ne eseguono un’altra; questo sempre volendo considerare i 27 violini risultanti come un’unica sezione);

quanto detto mi spingerebbe a dedurre che se, parlando in generale, io volessi ottenere in maniera semplice ed efficace una sezione di violini divisi (ad es. sempre 16 in totale), mi basterebbe caricare 2 sezioni da 8 violini ciascuna, prese da librerie differenti, in modo da poterle gestire separatamente,(sia facendole suonare all’unisono quando necessario, sia facendogli eseguire parti differenti),(non prese dalla stessa libreria, poichè ne risulterebbe un semplice aumento di volume o comunque rischierebbero di entrare in conflitto tra loro);

tuttavia mi chiedo… non c’è il rischio che esse risultino troppo differenti tra loro e poco omogenee, al punto da non sembrare un’unica sezione di strumenti, ma piuttosto 2 sezioni distinte (differenze di campionamento, riverbero,etc)?

Per di più, nei momenti in cui i due gruppi da 8 dovessero eseguire note differenti, non si annullerebbe il “beneficio” di cui parli utilizzando il layering (dato che di fatto sulla singola nota suonerebbero solo gli 8 violini di una singola libreria)?

E per finire una curiosità… quando utilizzi il layering, immagino tu unisca lo/gli strumento/i preso/i da due librerie per l’intera durata del brano, giusto? o addirittura cambi (e consigli di cambiare) varie librerie nel corso del progetto per eseguire anche solo un singolo strumento (o sezione)? (se posso dire la mia, non penso, poichè in tal caso temo che la coerenza e il realismo tenderebbero a svanire davvero).

Perdona se mi sono dilungato, ma l’orchestrazione digitale è un argomento che mi preme molto approfondire e vorrei poter ottenere il massimo dalle mie produzioni, anche in termini di realismo.

Una tua risposta/parere alle mie domande sarebbe molto utile.

P.S. Ovviamente ti prego di correggermi nel caso in cui alcune mie informazioni/supposizioni fossero errate.

Grazie mille in anticipo per l’attenzione e le risposte.

Daniele

Ciao Daniele.

Grazie per l’intervento così preciso e interessante.

Per scendere nei dettagli di ogni argomento ci vorrebbe tanto tempo, dedico al layering ore e ore di lezione. Cercherò di essere il più concisa possibile e indicare gli elementi essenziali.

Una premessa: mi sembra che ti preoccupi molto di replicare il numero esatto di strumentisti per raggiungere un effetto realistico.

Nella realtà l’orecchio umano non è così sensibile alle differenze di volume tra una formazione e l’altra come si potrebbe pensare.

Un esempio: dal punto di vista del “volume”, verrebbe da pensare che due violini suonino il doppio più forte di un violino solista.

Ma per il nostro orecchio il volume non è affatto raddoppiato, è solo “un po’ più forte”. I decibel aumentano in modo logaritmico e la differenza è di appena 3 decibel.

Se ne aggiungi un terzo, non triplichi: aggiungi ancora meno decibel del secondo violino. E ancora meno quando aggiungi il quarto violinista. Gia al quinto il contributo è quasi impercettibile.

Per questo nella grande orchestra hollywoodiana trovi sezioni enormi di strings (più strumentisti hai, più devi aggiungerne per ottenere anche la più minima differenza di decibel).

Mentre in una produzione attenta al budget 6 o 8 violini sono già abbastanza, specialmente se l’orchestratore è bravo.

La differenza che sentiamo in un ensemble è molto più relativa al tipo di suono (che per una sezione ampia di violini sarà più denso, più ricco) che al “volume”. Questo è il motivo per cui l’elemento essenziale non è la replica dell’esatto numero di strumentisti, ma la resa della sonorità.

E il controllo della sonorità è esattamente lo scopo del layering.

Detto questo, rispondo alle tue domande.

È vero che il layering dà un effetto innaturale? Dipende.

Semplificando: se prendo una patch di violini da due library distinte, una di bassa qualità con il riverbero di una sala da concerto, l’altra professionale con il riverbero di una cabina del telefono, sì, probabilmente otterrò un effetto molto “strano e innaturale”, come dici.

Se prendo due library professionali, tolgo loro il riverbero, invio tutti gli strumenti alla stessa plugin o allo stesso bus di riverbero, bilancio il pan e adatto la dinamica di ciascuna traccia, probabilmente l’effetto sarà molto realistico.

(Tieni anche presente che quello che ascolti nelle produzioni professionali è praticamente sempre layering.)

Come fare a controllare esattamente il numero di musicisti con il layering?

Hai diverse possibilità.

La prima e più consigliabile è di non preoccupartene. 🙂 È il senso del consiglio nell’articolo sul provare a ottenere un suono “esatto” e confrontarlo con quello ottenuto con il layering.

L’obiettivo è proprio quello di ottenere un suono realistico. Cercare di farlo col vincolo di contare gli strumenti che suonano è molto svantaggioso.

Altrimenti, prima di tutto usa direttamente più strumenti in Solo (ricorda che i round robin non si sommano ma si moltiplicano, cioé se ogni library ha lo stesso numero di round robin per due library sono al quadrato, per tre library arrivano al cubo).

Oppure usa library come EW Symphonic Orchestra, che hanno diverse patch per diverse formazioni (4 violini, 11 violini, 18 violini). Nel tuo esempio, potresti usare il patch 11 violini della EW Symphonic Orchestra, e 6 solisti dalle library che preferisci.

O il patch 11 violini e 5 solisti, e così via.

Però questo apre la strada a una serie di problemi audio dovuti alla cancellazione di fase: ovvero quando due forme d’onda simili sono sfalsate di qualche millisecondo e le oscillazioni si cancellano tra loro. (Nota che questo fenomeno non si verifica se raduni più strumentisti reali; perché questo avvenga è un po’ troppo complesso da spiegare qui.)

Comunque: se noti un improvviso abbassamento d’intensità sonora o di ampiezza del fronte sonoro, non aggiungere uno stereo widener al mix finale. È molto probabile che un solista stia cancellando l’altro.

Comunque sì, ci sono orchestratori virtuali che nei loro layout utlizzano *soltanto* strumenti in Solo, di ciascuna famiglia orchestrale, per riprodurre nel modo più fedele possibile ogni singola posizione degli strumentisti nello spazio, e poter controllare completamente le differenze di esecuzione.

Per quanto riguarda me: l’ho fatto, ho tratto le mie conclusioni e tendo a non farlo più. 🙂

È possibile gestire i divisi in layering?

Sì. Dal punto di vista del numero di strumenti tieni conto dei Solo di cui ti ho parlato. Dal punto di vista delle differenze di riverbero e effetti audio uniformando tutto come ti ho accennato nella prima risposta.

L’uso di più library durante il brano.

Sì, come immagini in genere uso le stesse library in parallelo per tutto il brano. A meno che non desideri un effetto particolare in un passaggio specifico. Ad esempio: un flourish di woodwinds eseguito da una library specializzata (hollywoodwinds, quelle di project sam, etc.) che adopero solo in quel momento.

Però di nuovo conta tantissimo “come suona”.

In questo aiuta molto avere esperienza di orchestrazione tradizionale (cioè, per strumentisti in carne e ossa) e sapere come suona lo stesso brano eseguito da un’orchestra vera.

Nella mia esperienza, anche una buona orchestra può sbagliare qualcosa. Questo anche se ha fatto le prove (e quindi non suona a prima vista facendo poi “splice ‘n dice” come è normale nella musica per immagini).

Invece, i virtual instrument non sbagliano mai. Quindi, più library adoperi, più ti avvicini al suono “impreciso” della realtà.

Per finire, considera che il layering si fa anche usando sessioni reali mixate con i virtual instrument. E una piccola/media orchestra (che suoni seguendo la clicktrack) viene facilmente trasformata in una grande orchestra da film facendo layering con i virtual instrument.

In questo caso naturalmente ti trovi con tante rese acustiche differenti e non c’è più nessuna correlazione tra numero di strumenti reali e virtuali: eppure alla fine funziona.

In una delle lezioni parto da un mio brano già inciso da un’orchestra e spiego come riarmonizzarlo parzialmente e estenderlo per venire incontro alla necessità della produzione di modificare durata e atmosfera del brano senza incorrere nel costo di una nuova sessione di incisione orchestrale.

È una settimana di lezione decisamente avanzata, ma oltre a essere uno skill che paga, serve a spiegare quanto possa essere ampio lo spazio di manovra con la tecnologia digitale.

E in casi come questo non ti puoi preoccupare di quanti strumentisti ci sono, dove siedono o dell’esatta acustica delle diverse sale.

Ti affidi a strumenti oggettivi (analizzatori di spettro e immagine spaziale, loudness meter, fase) e… all’Analizzatore Supremo, che è l’orecchio. 🙂

Buongiorno Susanna,

scusa ma ho letto solo oggi la tua risposta.

Ti ringrazio molto per il lungo ed esaudiente discorso,

direi che parecchie cose cominciano ad essere più chiare.

Per ciò che riguarda l’utilizzo dei samples in solo (come anche quello di piccole sezioni sovrapposte) esatto, la mia perplessità risiede proprio nel problema della cancellazione di fase… sperimenterò!

Riguardo quanto hai detto mi chiedo però alcune cose:

1) come si fa a eliminare il riverbero di registrazione dai samples? mi verrebbe da dire settando solo la microfonazione “close mic”, laddove presente…però so che anche in quel caso un minimo di ambiente viene comunque ripreso durante la registrazione degli strumenti, ed in tal caso aggiungere altra riverberazione virtuale sovrapposta ad esso darebbe poco realismo (ho appena iniziato un corso da fonico e così mi è stato detto anche da loro)

2) ascoltando i vari samples delle librerie orchestrali noto che sono praticamente sempre registrati già “pannati” nel panorama stereo secondo la disposizione tipica (violini a sinistra, contrabbassi a destra, etc…); c’è possibilità di spostarli? Ad esempio se li volessi portare momentaneamente tutti al centro per poi ridistribuirli stereofonicamente a mio piacimento. Possibile?

3) in conclusione il layering serve principalmente per l’effetto realismo…in termini di “piacevoli imprecisioni” che danno naturalezza, ma soprattutto, così mi è stato detto… per poter intervenire chirurgicamente solo laddove necessario, ad esempio per dare un accento all’attacco di una nota, o più in generale “correggere” le articolazioni a proprio piacimento. Ho inteso bene?

Grazie davvero per la pazienza e la disponibilità.

Daniele

Ciao Daniele,

rispondendo in ordine alle tue domande.

1) Il riverbero è possibile toglierlo anche se hai una registrazione molto “wet”, ma come giustamente osservi è più facile se hai una versione close.

È scomodo mettere esempi audio e immagini nei commenti, quindi ho aggiunto un paragrafo alla fine dell’articolo.

Ci sono esempi di rimozione del riverbero da ambiente e da una frase suonata dal trombone EastWest con il relativo spettogramma: dovrebbero rispondere alla tua domanda.

Importante! Non è necessariamente vero che aggiungere altro riverbero dia poco realismo.

È pratica standard adoperare uno o più bus di riverbero autentico (tipicamente IR, io uso QL Spaces che suona molto bene) per creare l’ambiente anche nelle library non proprio dry E POI aggiungere sopra a tutto un riverbero digitale, ad esempio un plate con una coda molto corta.

Il riverbero finale fa da collante, si usa spessissimo e non suona innaturale.

2) Se sono stati incisi in posizione li rendi mono (non ha molto senso che siano stereo) e li posizioni con il semplice pan. Questo è importante anche perché esistono tanti tipi di disposizione orchestrale.

3) Il layering serve a dare naturalezza e a rendere il suono “tuo”. Non direi che si usi chirurgicamente, solo per intervenire su una nota.

Personalmente se ho tempo faccio due o tre tracce di layering per ogni sezione. Alle volte per correggere, ma il più delle volte per creare un suono coeso e realistico.

4 (anche se non c’era un punto quattro)

Non c’entra nulla con quello che hai chiesto, ma un consiglio è di non pensare troppo agli aspetti tecnici e all'”esattezza” di quello che fai. Prova con un più musicale.

La migliore sample library (o la migliore orchestra) suona male se il pezzo è orchestrato in modo approssimativo.

Invece anche una vecchia library, con sopra 3 riverberi diversi, suona vera se l’orchestrazione è ben fatta e ti fai guidare dalle regole formali dell’orchestrazione e dall’orecchio più che dalla precisione nella posizione o nel numero degli strumentisti.

Buon lavoro!

Ciao Susanna, Buon Pomeriggio.

Grazie per le tue lezioni e per i tuoi consigli.

Grazie a questa pagine ho scoperto il Tuo canale Soundcloud.

Voglio chiederti una cosa che esula dalle Tue lezioni:

Pubblicare le composizioni o anche le idee (vedi l’ esempio con la melodia fatta dal corno francese), su questi canali (Soundcloud, Youtube, ecc.ecc) c’ è bisogno per forza di una registrazione se non SIAE, tipo Patamu o che altro ?

Nel senso: come fai a proteggere tutto ciò che pubblichi ?

L’ esempio che hai pubblicato che dura un minuto e poco più, che puoi riprendere, perchè Tuo, per una composizione più lunga…come fai a proteggerlo ?

Nella speranza che questa mia richiesta possa interessare, Ti chiedo comunque scusa se sono andato fuori tema.

Grazie ancora e Buon Lavoro.

Claudio

Ciao Claudio, grazie per le belle parole e la domanda interessante.

Non sono qualificata per esprimere pareri in materia legale, quindi ti consiglio di consultare un esperto (ci sono associazioni di musicisti che offrono questo servizio a costi accessibili).

Fatta questa premessa, il diritto d’autore coincide con la creazione dell’opera. Solo che in generale è difficile dimostrare che si è gli autori originali se non c’è una data certa di pubblicazione.

Oggi, tra internet, i servizi di digital right management (fingerprint) e gli archivi digitali è diventato molto facile disporre delle prove. E nel caso specifico della musica, col fingerprinting si può prevenire direttamente almeno alcuni usi non autorizzati.

I diritti delle mie musiche sono amministrati direttamente da me, o dall’azienda che dirigo, o trasferiti al cliente. (Insomma, dipende: ci sono tante situazioni diverse.)

Però quello che va bene per me non è detto che sia una buona idea per altri, quindi consiglio a tutti di sentire il parere di un legale specializzato (ovviamente non di parte e non interessato).

Ciao Susanna,

anche questa volta ho letto la tua risposta a distanza di molto tempo, perdonami…

Ti ringrazio davvero tanto per il tempo che mi hai dedicato con le tue utilissime risposte e per aver addirittura aggiunto la parte di rimozione del riverbero nell’articolo…:-)

P.S. Molti dei dubbi che ancora avevo a livello di resa audio, pan, etc. stanno via via trovando risposta anche grazie al corso da fonico che sto facendo… si trattava solo di avere un po’ di pazienza 🙂

Grazie ancora e buona serata!

Daniele

Scusa il disturbo, è da tantissimo tempo che cerco di trovare un suono in particolare. E’ il basso che parte da un tot di Hz e poi scende fino ad una frequenza molto bassa.. per capirci, quel suono che si mette di solito prima degli slow motion improvvisi nei film. Non so ne come farlo ne come si chiama.. Potresti aiutarmi?

Gent. ma Dott.ssa Quagliariello.

Ho letto quanto ha scritto e ammiro molto la Sua competenza altamente professionale.

Sono Marco Ferrarini di Campegine (RE), diplomato in composizione e laureato in Musicologia; in passato mi ero occupato di basi musicali per spettacoli teatrali e scuole di musica, utilizzando Cakewalk e Pro Audio 9 (… in effetti è passato molto tempo e ora ho 49 anni). Già all’epoca avevo intuito diverse cose che Lei espone e questo è stato per me una graditissima conferma (mi ero inventato anche diversi trucchi per ottenere effetti non previsti dal programma).

Dopo tanti anni, vorrei riprendere con la musica digitale, puntando sul discorso “colonne sonore”.

Vengo al dunque: se volessi ricominciare seriamente, rimanendo il più possibile legato allo stile “orchestra sinfonica” ma senza disdegnare gli “effetti”, percussioni etniche e batteria, e volendo lavorare soprattutto in midi (al massimo uno strumento solista in audio, tutto il resto rigorosamente in midi ma con molto editing e umanizzazioni varie), quale di questi programmi mi consiglierebbe, magari specificando anche il sistema operativo più opportuno (Windows / Mac)?

Cubase / Logic Pro / Ableton / Nuendo

… o anche altro che non conosco.

Cordiali saluti

Marco Ferrarini

Buongiorno Susanna sono un organista e compositore sicuramente di altri tempi essendo nato nel 1961. La mia formazione è accademica: tanto tempo fa, mi sono diplomato in pianoforte, organo e composizione organistica, composizione principale. Per tutta la vita mi sono occupato e mi sto occupando di concertismo e composizione. Pur esprimendo tutto il mio rispetto verso la tua persona posso affermare con tutta sicurezza che la composizione Non può essere spiegata ed insegnata con un insieme di nomi dal sapore anglo-americano. Credo che con questi principi tecnologici traballanti, ai ragazzi non si faccia un buon servizio e anzi si confondono le idee. Auguri Comunque per il tuo lavoro. Maestro Francesco Galli

Ciao Francesco, capisco perfettamente il tuo atteggiamento, perché in passato ho pensato le stesse cose.

Diciamolo: per chi come noi ha alle spalle un’educazione formale di musica, la tecnologia digitale e i software di composizione sembrano di primo acchito una scorciatoia per risultati mediocri.

La lingua, poi: com’è possibile che la musica, un’arte scritta letteralmente in italiano (dalle indicazioni di dinamica a quelle di ritmo, dalle informazioni sulla tecnica di esecuzione a quella di espressione) oggi debba fare i conti anche con altre lingue?

Poi ho iniziato a studiare questo mondo, e ne ho capito le potenzialità per lo studio, per la ricerca sul suono, per la composizione.

E così hanno fatto i Conservatori, e tutti gli istituti di formazione musicale del mondo, che si sono aperti già da tempo a queste stesse tecnologie.

E ho capito che, esattamente come nell’Ottocento sarebbe stato impensabile per un musicista non imparare termini in italiano, oggi è altrettanto impensabile non imparare termini in inglese. A meno di volersi autoescludere dai vantaggi che il mondo di oggi ci offre, e condannarsi a vivere nel passato.

Ma che peccato limitarsi.

In bocca al lupo per il tuo lavoro, e buona musica!